Svetainės indeksavimo valdymas: Skirtumas tarp puslapio versijų

| 298 eilutė: | 298 eilutė: | ||

[[Kategorija:Talpinimo plano naudojimas]] | [[Kategorija:Talpinimo plano naudojimas]] | ||

| + | [[Kategorija:Profesionalus_hostingas]] | ||

Dabartinė 10:06, 27 gegužės 2024 versija

Paieškos sistemų robotai ir skaitytuvai neretai indeksuodami Jūsų svetainę gali sukelti jos neveikimą, serverio apkrovą, kadangi dauguma paieškos sistemų robotų, tokie kaip „Googlebot“, „Bingbot“, „Yandex Bot“ ir kt., siekia kuo greičiau suindeksuoti svetaines. Svetainių indeksavimas taip pats svarbus svetainės SEO, jos aptinkamumui paieškos sistemose, tačiau svarbu atkreipti dėmesį, kad toks indeksavimas neturėtų sukelti pačios svetainės neveikimo.

Todėl svarbu valdyti Jums reikalingus ir aktualius paieškos sistemų sistemų robotus ir jų indeksavimo intensyvumą, kad nenukentėtų nei svetainės SEO, nei jos pasiekiamumas indeksavimo metu, kai generuojamas didelis kiekis užklausų iš paieškos sistemų robotų.

Turinys

[slėpti]Ahrefs indeksavimo nustatymai

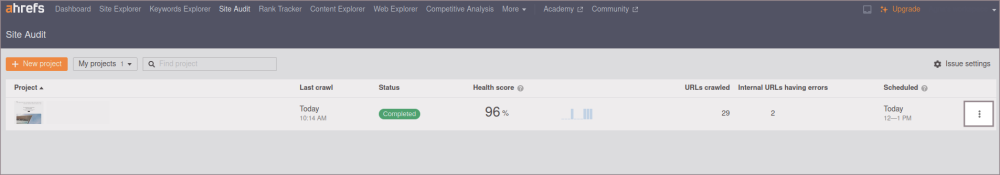

Ahrefs yra vienas iš SEO įrankių, kuris skirtas padėti svetainių savininkams, skaitmeninės rinkodaros specialistams ir SEO ekspertams analizuoti ir tobulinti savo svetainių našumą paieškos sistemose. Šio įrankio indeksavimo nustatymus galite valdyti prisijungę prie įrankio valdymo: https://ahrefs.com/

1. Ties pridėtu projektu paspauskite trijų taškelių simbolį:

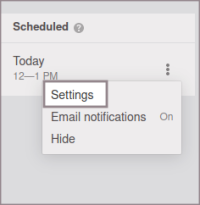

2. Pasirinkite "Settings":

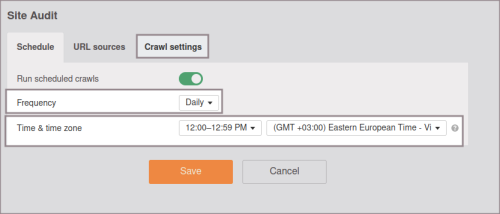

3. Pirmoje skiltyje "Schedule" galite nustatyti laiko intervalą ir dažnumą - kuriomis valandomis ir kaip dažnai bus atliekamas svetainės indeksavimas. Pasirinkite norimus nustatymus paspauskite "Crawl settings":

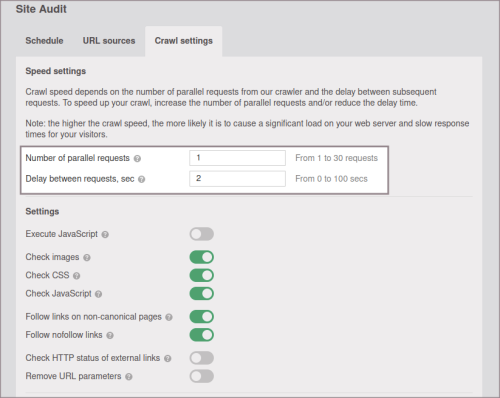

4. Nustatymų skiltyje galite nustatyti kiek paralelių užklausų bus galima generuoti į svetainę ir koks turėtų būti laiko tarpas tarp užklausų, pavyzdžiui, nustačius Delay between request, sec: 20, o Number of paraller requests:1, į svetainę ateis po 1 užklausą kas 20 sec:

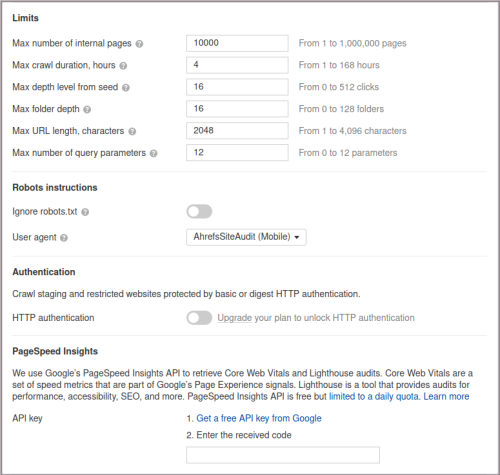

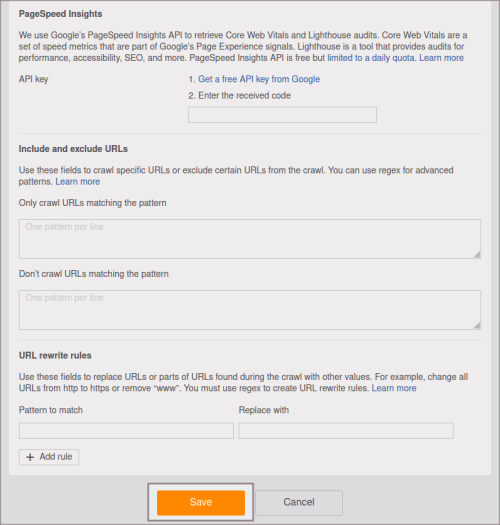

5. Žemiau galite valdyti papildomus nustatymus, pavyzdžiui, vidinių puslapių skaičių, maksimalią indeksavimo trukmę, URL ilgį:

6. Pasirinkę norimus nustatymus paspauskite "Save" ir juos išsaugokite:

Semrush indeksavimo nustatymai

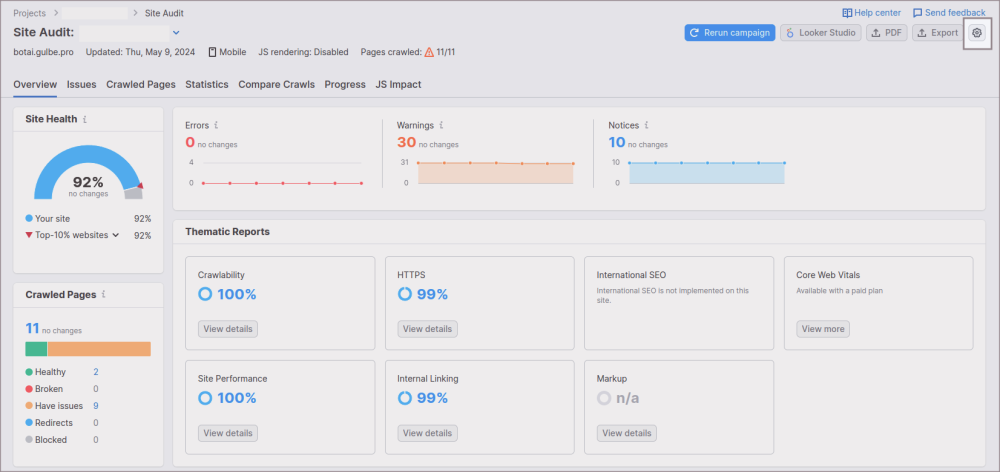

Semrush yra vienas iš įrankių, skirtų stebėti svetainės SEO. Nustatymus galite valdyti prisijungę prie jų įrankio:

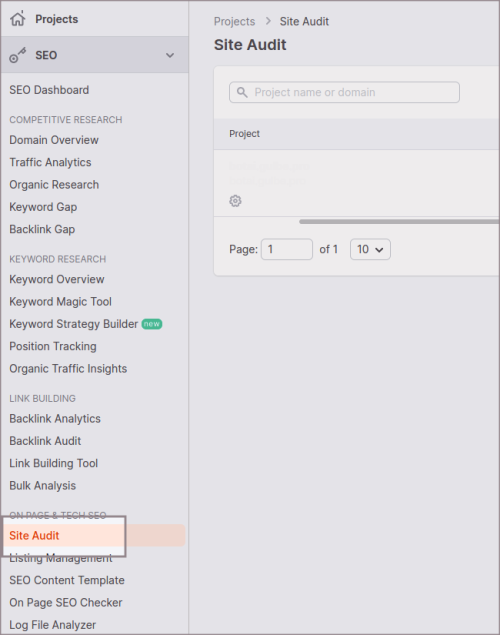

1. Prisijungę pasirinkite skiltį "Site Audit":

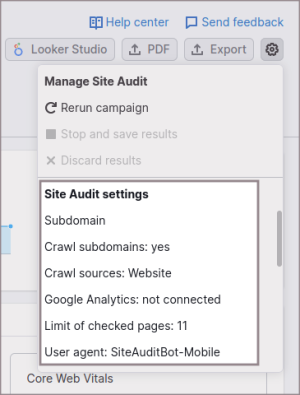

2. Paspauskite nustatymų simbolį:

3. Paspauskite ant vieno iš pasirinkimų "Site Audit settings" skiltyje:

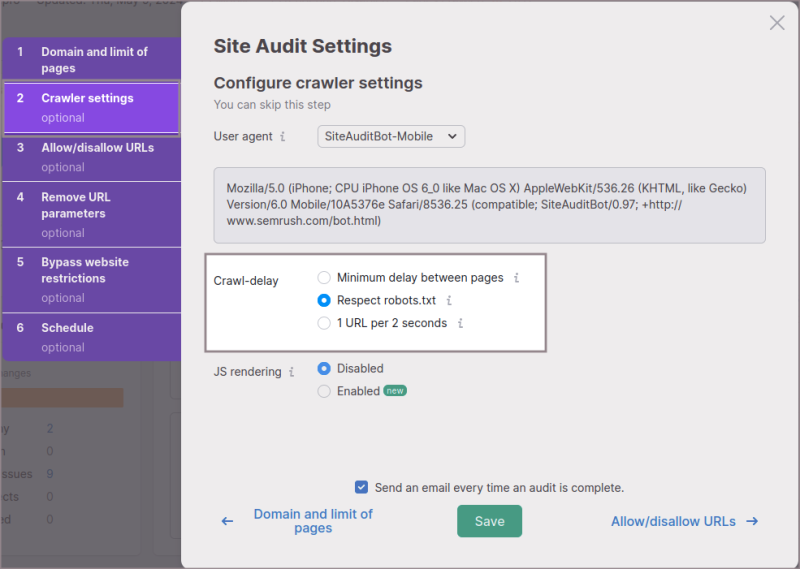

4. Peržiūrėkite "Crawler settings", kur galite pažymėti, kad būtų atsižvelgiama į svetainės robots.txt failą, arba sulėtinti užklausas iki 1 URL per 2 sekundes:

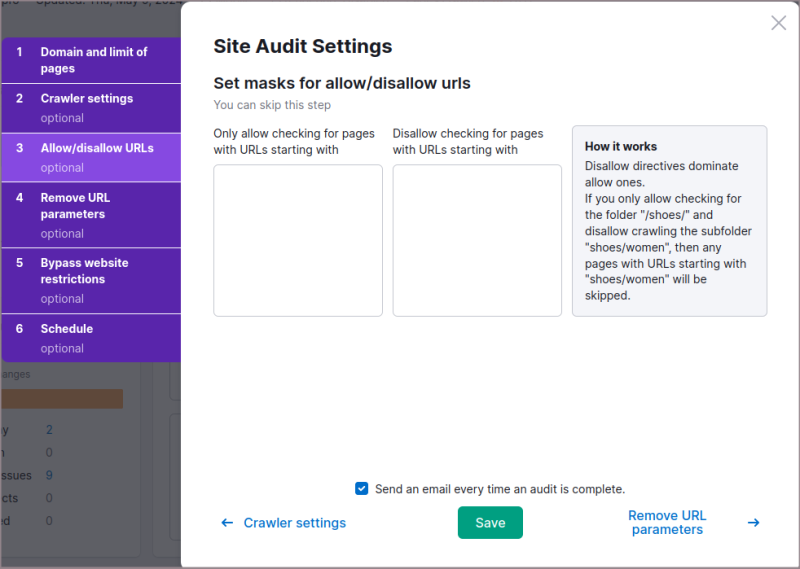

5. Skiltyje "Allow/disallow URLs" galite įrašyti URL nuorodų pradžią, kurių norite, kad įrankis netikrintų arba tikrintų:

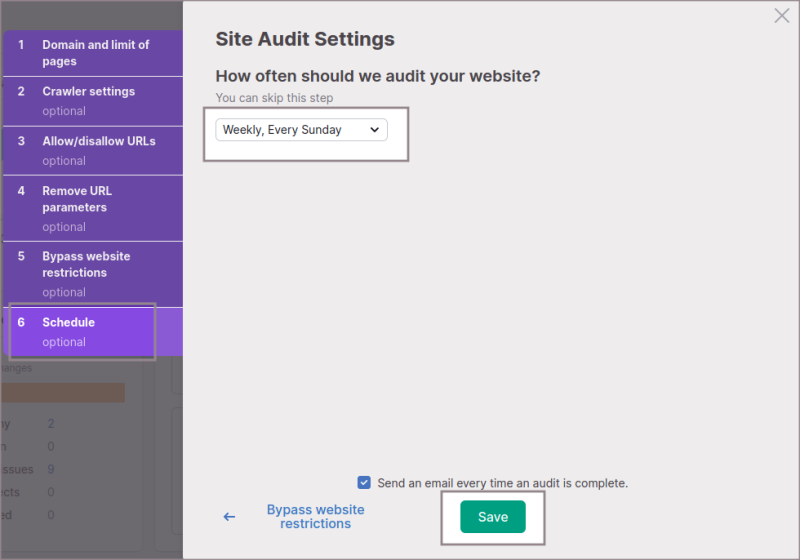

6. Pasirinkite, kokiu intensyvumu svetainė turi būti indeksuojama ir išsaugokite:

BingBot indeksavimo nustatymai

Bingbot yra „Microsoft Bing“ paieškos sistemos naršymo robotas. Jo pagrindinė funkcija yra nuskaityti ir indeksuoti interneto svetaines, kad jų turinys būtų įtrauktas į „Bing“ paieškos rezultatus.

Nustatymus galite valdyti Bing webmasters tools įrankio pagalba:

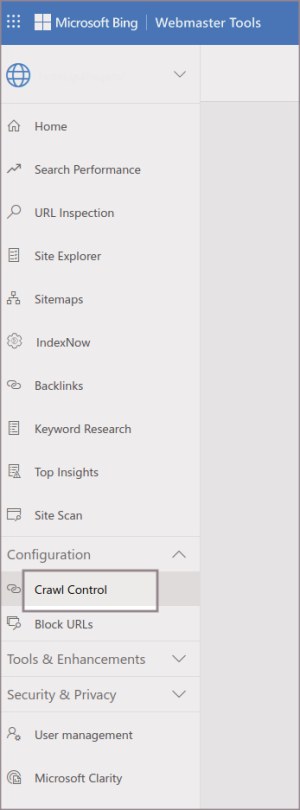

1. Prisijungę pasirinkite "Crawl Control":

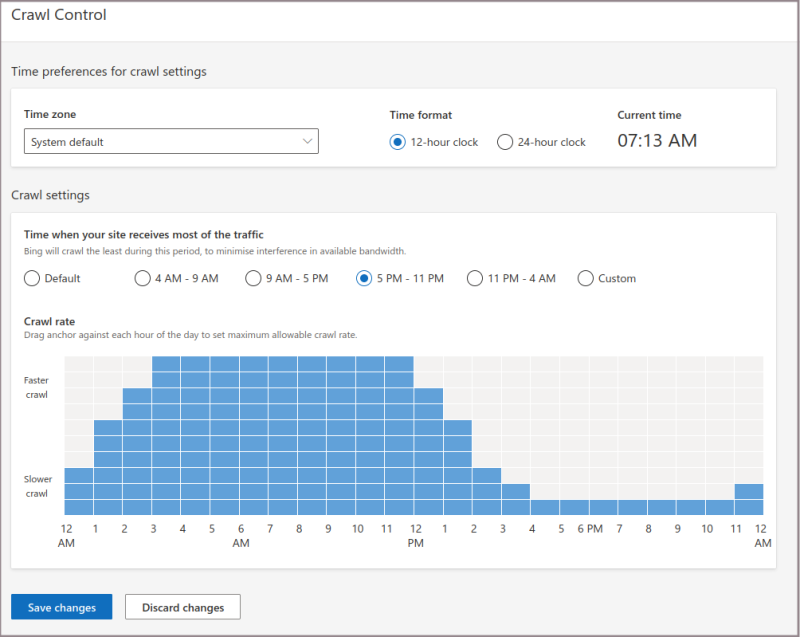

2. Kur galėsite pasirinkti kokiu laiku ir kuriomis valandomis svetainę galima indeksuoti greičiau, o kokiu laiku, pavyzdžiui, kai svetainės lankomumas yra didelis, indeksuoti lėčiau:

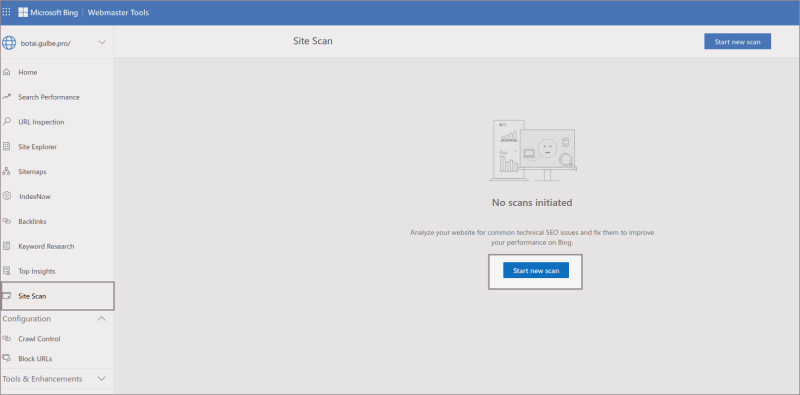

3. Konkretaus indeksavimo nustatymus taip pat galima kontroliuoti inicijavus indeksavimą. Pasirinkite "Site scan" ir "Start new scan":

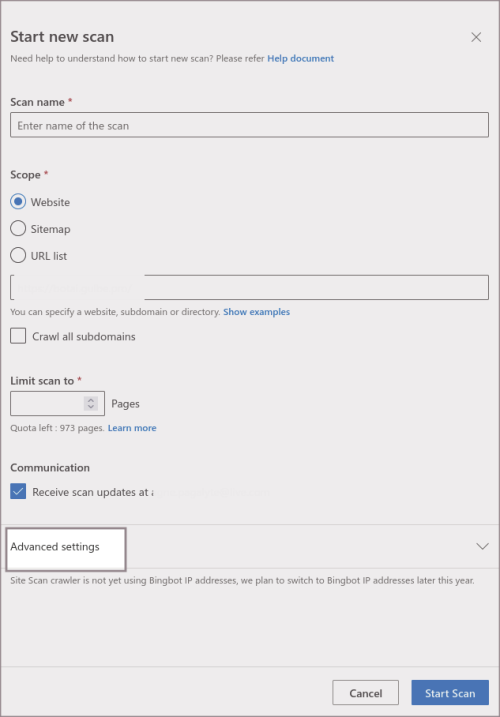

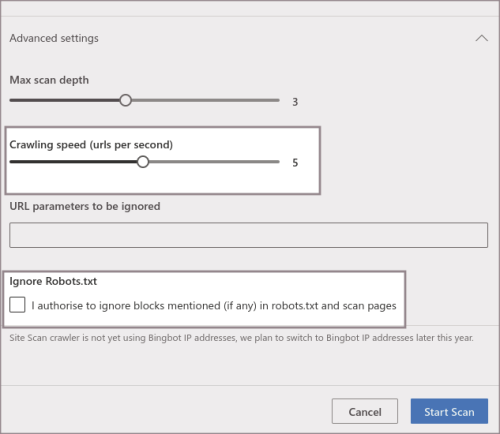

4. Pasirinkite "Advanced settings":

5. Pasirinkite, koks turėtų būti indeksavimo greitis (crawling speed (urls per second) ir patikrinkite, kad nebūtų ignoruojamas turimas robots.txt failas:

robots.txt failo valdymas turinio valdymo sistemos administravimo dalyje

Paieškos sistemų robotų ir skaitytuvų šiuo metu yra labai daug. Nėra galimybės užsiregistruoti kiekvieno iš jų įrankyje, skirtame indeksavimo valdymui. Taip pat ne kiekvienas robotas turi įrankį, kurio pagalba galite valdyti, kaip jis indeksuos svetainę, kadangi svetainę gali indeksuoti ne tik paieškos sistemų robotai ( Yandex, Google, BingBot), bet ir tokie botai kaip Alexa ( Amazon virtualus asistentas), Siri (Apple sukurta virtuali asistentė), socialinių tinklų botai, turinio valdymo sistemų, duomenų rinkimo, dirbtinio intelekto ir kt. Tad visų jų indeksavimo valdyti tam tikru įrankiu nebus galimybės. Šioje situacijoje svarbu tinkamai apsirašyti robots.txt failą, kuriame reikalinga nurodyti, kurias svetaines dalis galima indeksuoti, o kurių indeksuoti paieškos sistemų robotams negalima, pvz., prisijungimo prie administravimo dalies puslapio ir pan.

Sukurti crawl-delay taisykles, kurios sulėtins roboto užklausų skaičių iki 1 užklausos per Jūsų nurodytą laiko periodą. Tačiau svarnu atkreipti dėmesį, kad ne visi robotai paiso crawl-delay nustatymų, todėl įsivertinus neaktualius robotus, jiems prieigą reikėtų uždrausti.

Kaip robots.txt failą galima valdyti serverio lygmenyje galite matyti čia

Tačiau kartais tai patogu atlikti ir iš turinio valdymo sistemos administravimo dalies, tuo labiau, kad kai kurios sistemos sugeneruoja standartinį failą su iškart įtrauktomis nuorodomis, kurių indeksuoti negalima, o kurias galima.

Wordpress

1. Turinio valdymo sistemoje robots.txt failą galima valdyti įskiepio pagalba, vienas tokių Yoast SEO. Instaliuokite šį įskiepį paspaudę "Install":

2. Paspauskite "Activate":

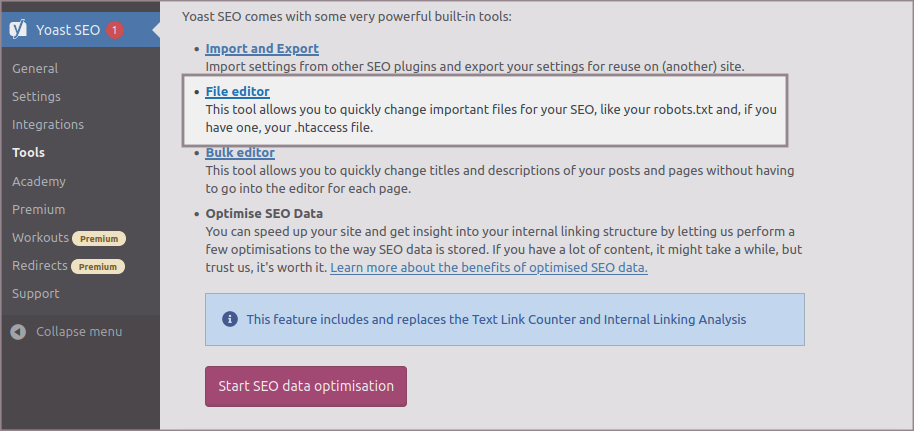

3. Pasirinkite "Tools" skiltį šio įrankio meniu:

4. Pasirinkite "File Editor":

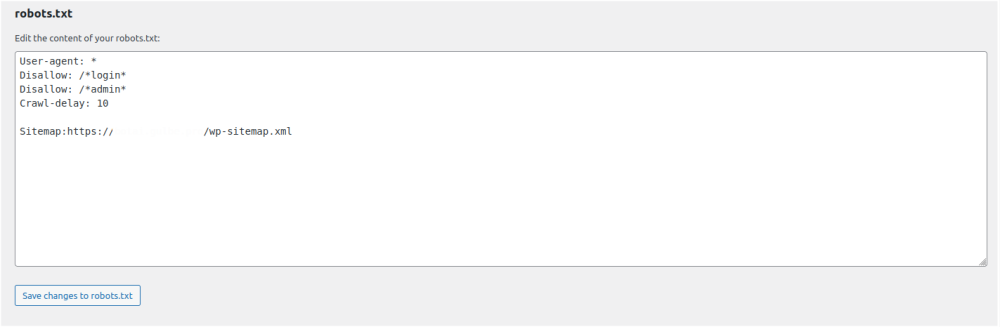

5. Jums bus pateiktas toks failas, koks yra serveryje, jį koreguoti galėsite per administravimo aplinką ir visi pakeitimai bus išsaugoti:

Prestashop

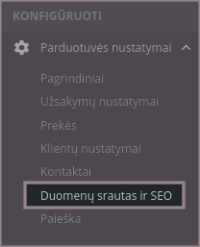

1. Prisijunkite prie turinio valdymo sistemos Prestashop administravimo dalies ir pasirinkite "Duomenų srautas ir SEO" (Traffic & SEO) skiltyje "Konfigūruoti" (Shop Parameters):

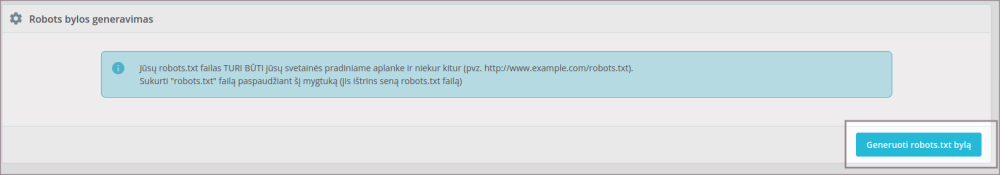

2. Pačioje nustatymų apačioje matysite skiltį "Robots bylos generavimas" (Robots file generation) ir mygtuką "Generuoti robots.txt bylą" (Generate robots.txt file):

Pavyzdinis Prestashop sistemos sugeneruoto failo turinys:

| Išplėsti |

|---|

SVARBU: šis sugeneruotas failas perrašys robots.txt failą, jei serveryje toks yra sukurtas.